- 从三个地方入手修改了SRGAN:

- 网络结构

- adversarial loss

- perceptual loss

- 网络结构主要是引入了RRDB的结构,并且去掉了BN层,使用residual scaling和smaller initialization,就是residual在加的时候乘一个小于1的系数,在w初始化的时候用更小的varience

- adversarial loss是把discriminator 修改为Relativistic average GAN:

公式是这样的:

D

R

a

(

x

r

,

x

f

)

=

σ

(

C

(

x

r

)

−

E

x

f

[

C

(

x

f

)

]

)

D_{Ra}(x_r, x_f ) = σ(C(x_r) − E_{x_f} [C(x_f )])

DRa(xr,xf)=σ(C(xr)−Exf[C(xf)]),

E

x

f

E_{x_f}

Exf是指在一个minibatch的fake data里面取均值,

σ

(

⋅

)

σ(·)

σ(⋅)是一个sigmoid function,所以对discriminator和generator来说,loss分别是

公式是这样的:

D

R

a

(

x

r

,

x

f

)

=

σ

(

C

(

x

r

)

−

E

x

f

[

C

(

x

f

)

]

)

D_{Ra}(x_r, x_f ) = σ(C(x_r) − E_{x_f} [C(x_f )])

DRa(xr,xf)=σ(C(xr)−Exf[C(xf)]),

E

x

f

E_{x_f}

Exf是指在一个minibatch的fake data里面取均值,

σ

(

⋅

)

σ(·)

σ(⋅)是一个sigmoid function,所以对discriminator和generator来说,loss分别是

- perceptual loss是把原先比较activation function后的feature map改为比较activation层之前的feature map,而且探索了把VGG从分类任务的pretrained变成recognition任务的pretrained,认为这样的VGG更注重纹理,虽然只获得了微小的margin

- BN层去掉是因为如果test和train有不同的分布,会引入不合理的纹理,去掉效果更好,一般SR和debluring都会去掉

- 最终的loss是这样的 L G = L p e r c e p + λ L G R a + η L 1 L_G = L_{percep} + λL^{Ra}_G + ηL_1 LG=Lpercep+λLGRa+ηL1其中 L 1 = E x i ∣ ∣ G ( x i ) − y ∣ ∣ 1 L_1=E_{x_i}||G(x_i) − y||_1 L1=Exi∣∣G(xi)−y∣∣1,是SR和GT差的L1norm

- 提出一种network interpolate的方法,即先用PSNR-orentied的loss训练出来一个generator,在此基础上再用上本论文提出的ESRGAN的模型去finetune它得到另一个状态下的参数,并对这两个generator参数进行插值可以得到一系列的网络参数,分别对应从平滑到sharp的SR模型参数。其实还有另外两种方法来获得这个效果,一个是对两个模型生成的图片直接进行插值,但是结果有噪声和模糊,另一个是对loss函数的超参数值进行插值,但是这样太costly

ESRGAN阅读笔记

news/2025/2/26 13:16:55

相关文章

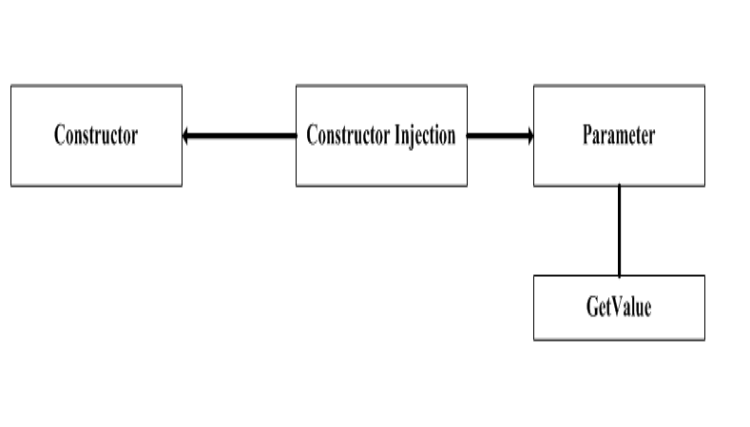

Inside ObjectBuilder Part 2

Object Builder Application Block文/黃忠成2006/9/21 三、ObjectBuilder Application BlockObjectBuilder一開始出現於Microsoft所提出的Composite UI Application Block,主司物件的建立及釋放工作,她實現了本文前面所提及的Dependency Injection概念&a…

嵌入式系统学习笔记(1)——概述、发展历史

TTL电平高电平为5V低电平为0V,计算机串口使用RS232电平,高电平为-12V低电平为12V,所以使用TTL电平的单片机和计算机通讯时需要通过电平转换芯片max23251单片机是对8051单片机衍生系列的统称,STC是其中一种,STC是公司的…

Inside ObjectBuilder Part 4

ObjectBuilderApplicationBlock文/黄忠成2006/9/21八、ObjectBuilder实务8-1、ObjectBuilderWithConfiguration截至目前为止,本文一直以程序方式来配置ObjectBuidler建立对象所需的各种对象,但在实务上,这些动作应该是交由配置文件来负责&…

Towards Precise Supervision of Feature Super-Resolution for Small Object Detection 阅读笔记

Better to Follow, Follow to Be Better: Towards Precise Supervision of Feature Super-Resolution for Small Object Detection

文章针对2阶段的detection提出了一种对小面积ROI的feature进行SR的方法,并提出了对该SR进行监督的机制首先是发现问题,问…

Inside ObjectBuilder 范例

Object Builder Application Block文/黃忠成2006/9/21一、IoC 简介IoC 的全名是“Inversion of Control”,字面上的意思是“控制反转”,要了解这个名词的真正含义,得从“控制”这个词切入。一般來说,当程序员撰写一个Console 程序…

Asp.net 2.0 自定义控件开发[创建自定义右键PopupMenu控件][示例代码下载]

(一). 概述1. 当鼠标悬浮到控件对象上, 右击, 会弹出此自定义控件.2. 仅当控件支持oncontextmenu事件. 另外, 与其功能类似的控件[浮动Toobar自定义控件](二). 运行如图(三). 用法1. 将PopupTraceMenur控件Dll添加引用到Web站点工程中2. 从工具箱拖动一个PopupTraceMenu控件和另…

![Asp.net 2.0 自定义控件开发[创建自定义右键PopupMenu控件][示例代码下载]](https://p-blog.csdn.net/images/p_blog_csdn_net/ChengKing/RightClickPopupMenu%28XFRAME%29.JPG)